Meta Llama 4 发布 36 小时“差评如潮”,匿名员工爆料拒绝署名技术报告

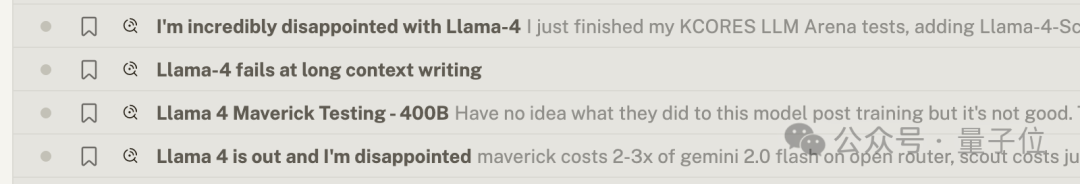

Meta 最近发布的基础模型 Llama 4 在上线 36 小时后,评论区竟然出现了这样的情况:

失望,实在是太失望了

不太清楚他们在后续训练中做了什么,总的来说效果不佳

在 [各类测试中] 表现不佳

……

还被制作成表情包进行调侃,总结就是“差评如潮”。

具体来说,大家的抱怨主要集中在代码能力上。

最直接的反馈来自经典的“氛围编程”小球反弹测试,小球竟然直接穿过墙掉了下去。

在排名上也表现得很不一致。

发布时官方测评(LiveCodeBench)的分数和在大模型竞技场的表现本来都很不错。

但在众多第三方基准测试中,情况却大多相反,排名靠后。

这不禁让人怀疑,这个竞技场排名究竟是数据过拟合,还是有刷票现象。

在 Llama 4 即将发布的前几天,Meta AI 研究主管 Joelle Pineau 在工作了 8 年后突然宣布离职,这显然是个不利的消息。

Llama 4 发生了什么?

在大模型爱好者激烈实践和吐槽的同时,一则关于 Llama 4 的匿名爆料,意外引发了广泛关注:

有网友表示自己已向 Meta GenAI 部门提交辞职,并宣称不希望在 Llama 4 的技术报告上署名。

这条信息最初发布在海外留学求职交流平台一亩三分地,随后在国内引发了诸多讨论。

此爆料目前尚无确凿证据,但有人提到了 Meta GenAI 负责人 Ahmad Al-Dahle 的帖子,至少可以看出在 Llama 4 大模型竞技场中运行的似乎是特别版本模型。

此外,还有以前的 Meta 员工借此机会发布 2024 年 11 月的一项研究,指出自 Llama 1 起就存在数据泄露的问题。

不仅仅是编程能力出现问题,在 EQBench 测评基准的长文写作排名中,Llama 4 系列也直接落在了最底层。

榜单的维护者 _sqrkl 说明了具体情况。

测试过程非常简单,模型需要先完成短篇小说的头脑风暴、反思并修改写作计划,接着每轮写作 1000 字,重复进行 8 轮以上。

由 Claude-Sonnet 3.7 担任评判,每个章节单独评分,最后还要对整部作品进行评分。

Llama 4 的低分表现在于后期内容大量重复,以及写作风格相当公式化。

对此结果,有一种猜测认为,之前的版权诉讼让 Meta 删除了网络和书籍的数据,转而使用了更多的合成数据。

在这场诉讼中,许多作家发现他们的作品可能被用于 AI 的训练,并在伦敦的 Meta 办公室附近发起了抗议。

Llama 4 发布后的种种情况,让人联想起年初某匿名员工的爆料,有网友表示原本只是随便看看,而如今却开始相信这些说法:

在这条爆料中提到,Deepseek V3 发布后,正在训练的 Llama 4 显得格外落后,中层管理的薪水甚至超出了 DeepSeek V3 的训练成本,Meta 内部随之陷入了恐慌状态。

不由得让人感慨,DeepSeek-R1 横空出世仅仅两个月时间,仿佛经历了好几代。

参考链接:

-

[1]https://www.reddit.com/r/LocalLLaMA/comments/1jt7hlc/metas_llama_4_fell_short/

-

[2]https://www.1point3acres.com/bbs/thread-1122600-1-1.html

-

[3]https://x.com/suchenzang/status/1909070231517143509

-

[4]https://x.com/TheAhmadOsman/status/1908833792111906894

本文来自微信公众号:量子位(ID:QbitAI),作者:梦晨,原标题《Llama 4 发布 36 小时差评如潮!匿名员工爆料拒绝署名技术报告》