苹果发布 FastVLM 视觉语言模型,为新型智能眼镜等穿戴设备铺路

GoodNav 报道,苹果上周开源了视觉语言模型 FastVLM,包含 0.5B、1.5B 和 7B 三个版本。

该模型由苹果自研 MLX 框架开发,并基于 LLaVA 代码库训练,针对 Apple Silicon 芯片的端侧 AI 运算进行了优化。

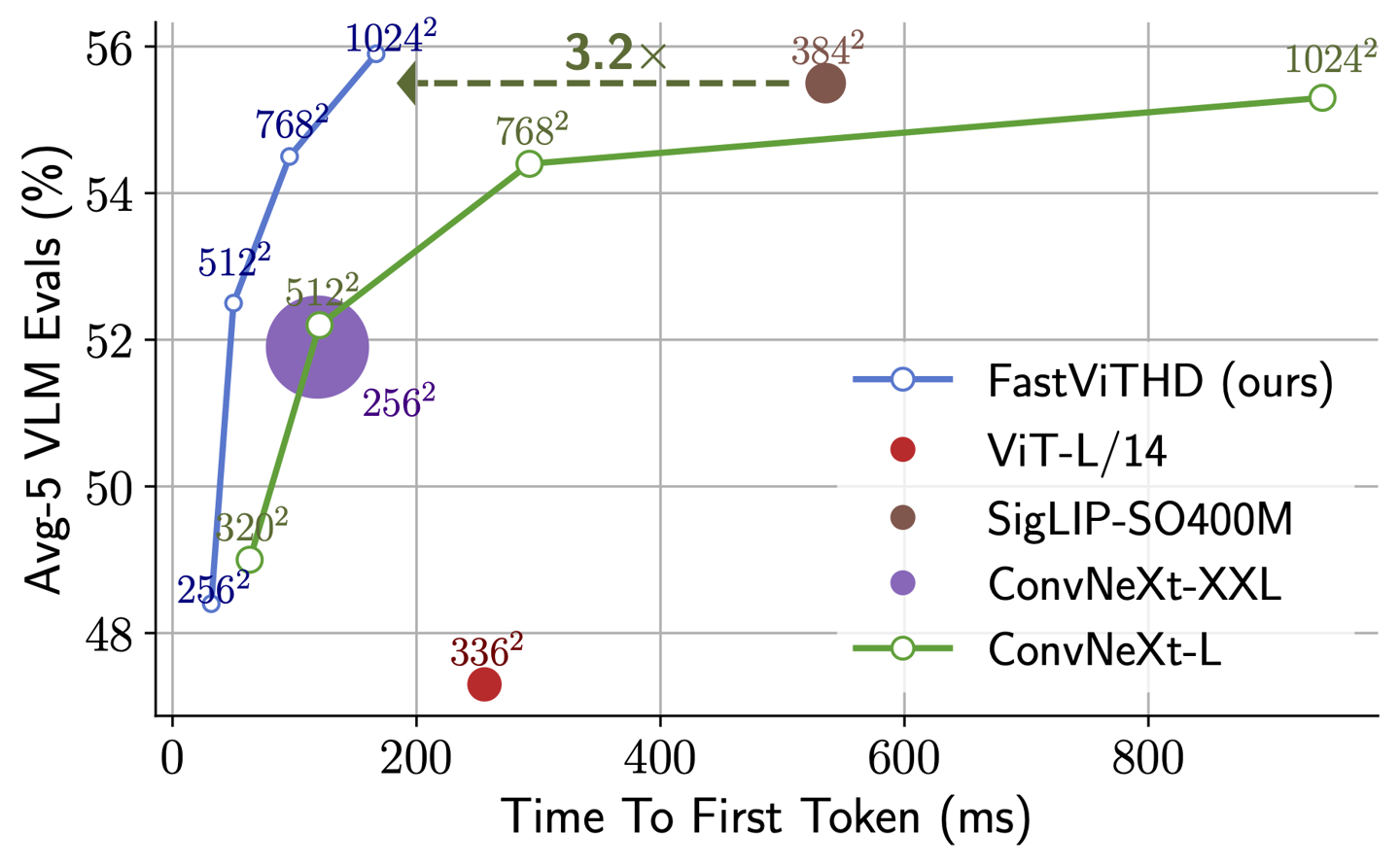

FastVLM 在保证精度的情况下,实现了高分辨率图像的近实时处理,且计算量显著低于同类模型。

FastVLM 的核心是 FastViTHD 混合视觉编码器,该编码器优化了高分辨率图像处理。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...