Meta LIama 4 重夺开源第一:DeepSeek 同等代码能力但参数减半,一张 H100 就能跑,还有两万亿参数超大杯

周末只是个名字,硅谷照常忙碌。在一个阳光明媚的周日,Llama 家族迎来了新成员,一群 Llama 4 模型就这样悄然发布了。

这是 Meta 的第一个基于 MoE 架构的模型系列,目前共有三款:

Llama 4 Scout、Llama 4 Maverick、Llama 4 Behemoth。

最末款尚在筹备阶段,Meta 已经公开表示前两款是“迄今为止我们最先进的型号,以及同类产品中最佳的多模态型号”。

让我们关注一些关键词 ——

-

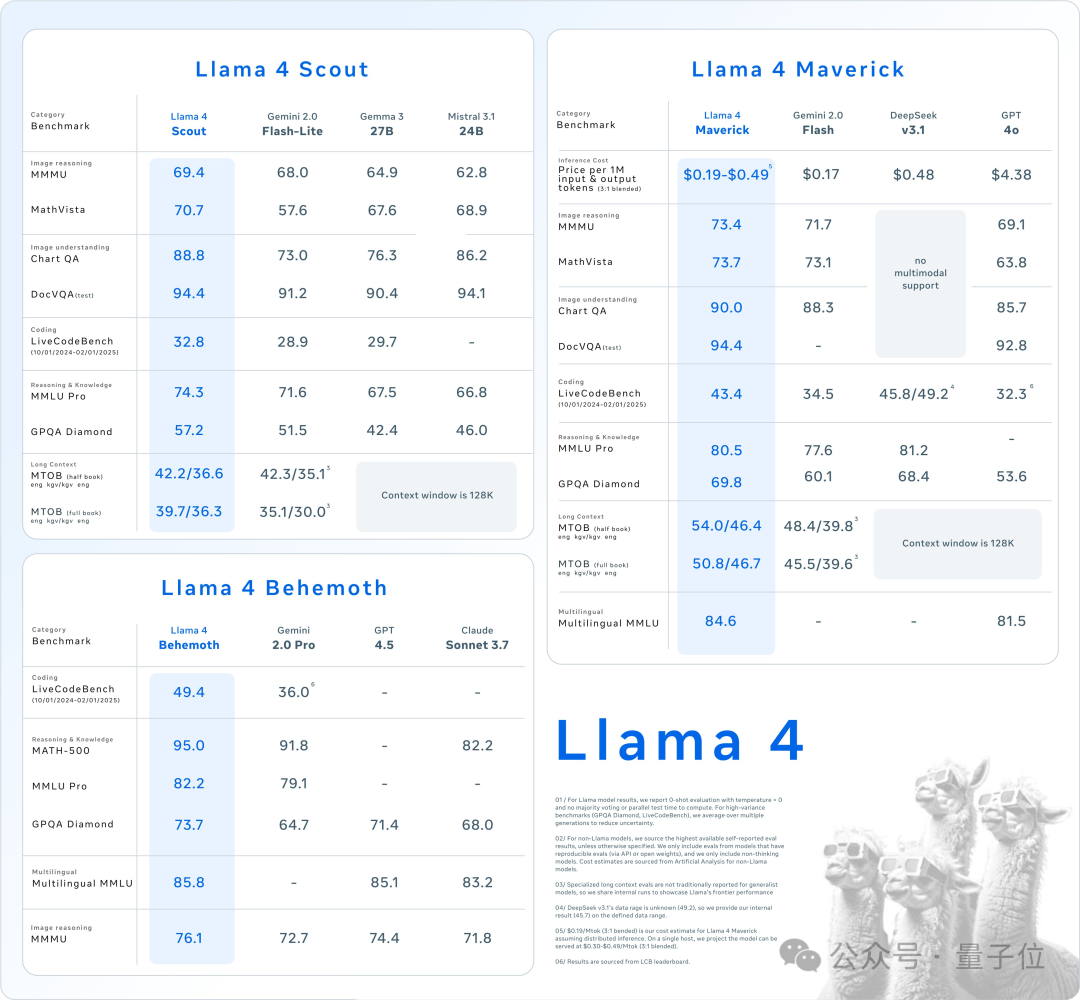

Llama 4 Scout,16 位专家的 170 亿激活参数的多模态模型,可在单个 H100 GPU 上运行,达到了同类 SOTA 的水平,并具备 10M 的上下文窗口。

-

Llama 4 Maverick,128 位专家的 170 亿激活参数多模态模型,超越 GPT-4o 和 Gemini 2.0 Flash,其与 DeepSeek-V3 的性能持平,但参数仅为其一半,主打与 DeepSeek 类似的性价比,在单个 H100 主机上可实现运行。

-

Llama 4 Behemoth:拥有 2 万亿参数的超大模型,上述两款均为其提炼而来;目前正在训练中;在多个基准测试中已超越 GPT-4.5、Claude Sonnet 3.7 和 Gemini 2.0 Pro。

Meta 官方Twitter兴奋地表示,这些 Llama 4 模型象征着 Llama 生态系统的新纪元——原生多模态 AI 创新的起点。

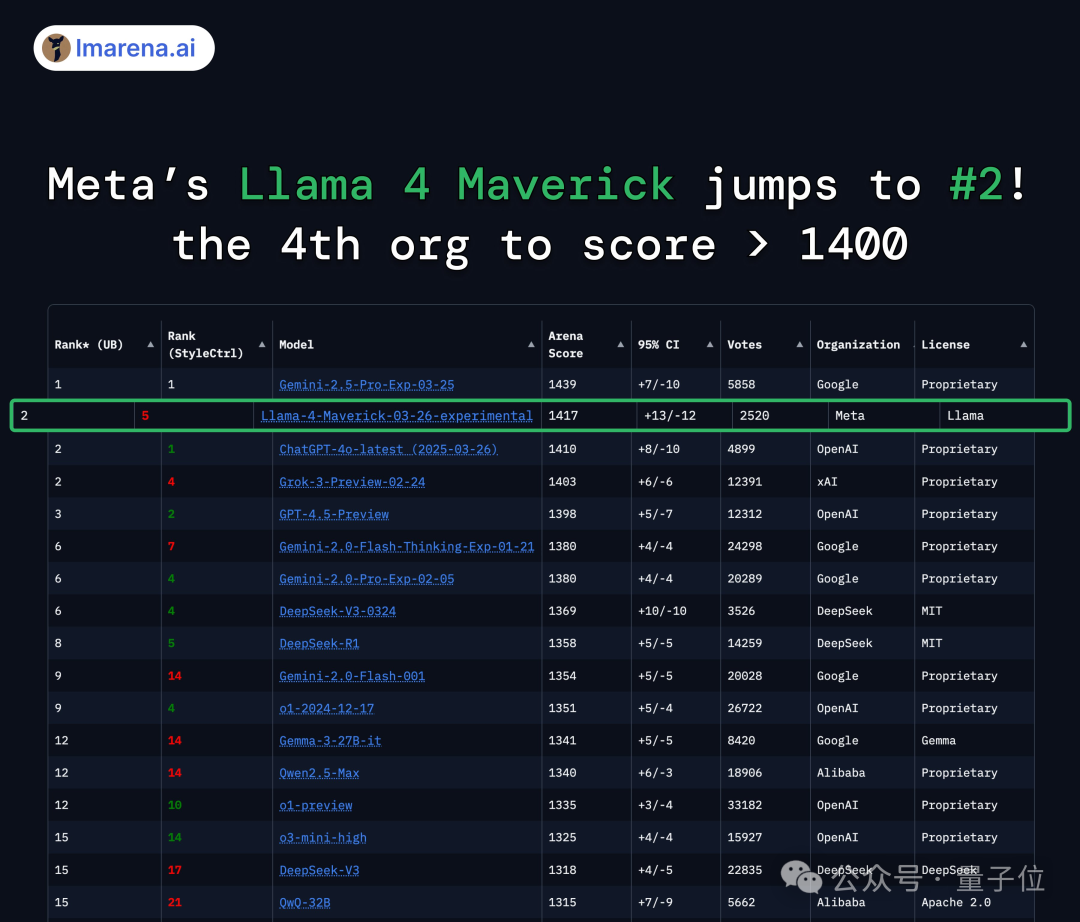

与此同时,大模型的竞技排名也进行了更新。

新发布的 Llama 4 Maverick 在编码、数学、创意写作和困难提示上并列第一,得分达到 1417。这不仅大幅超越了 Meta 之前的 Llama-3-405B(提升了 149 分),还成为历史上第四个突破 1400 分的模型。

并且得分情况非常明确——超越 DeepSeek-V3,一出场就夺得第一个排名的开源模型。

谷歌 CEO 劈柴哥迅速发来祝贺:

AI 的世界,从不平淡!

恭喜呀!Llama 4 团队,继续前进!

中杯和大杯首次亮相

在了解了 Llama 4 系列的所有成员后,我们先来看看首次发布的两款模型:

<ul class=\"list-p